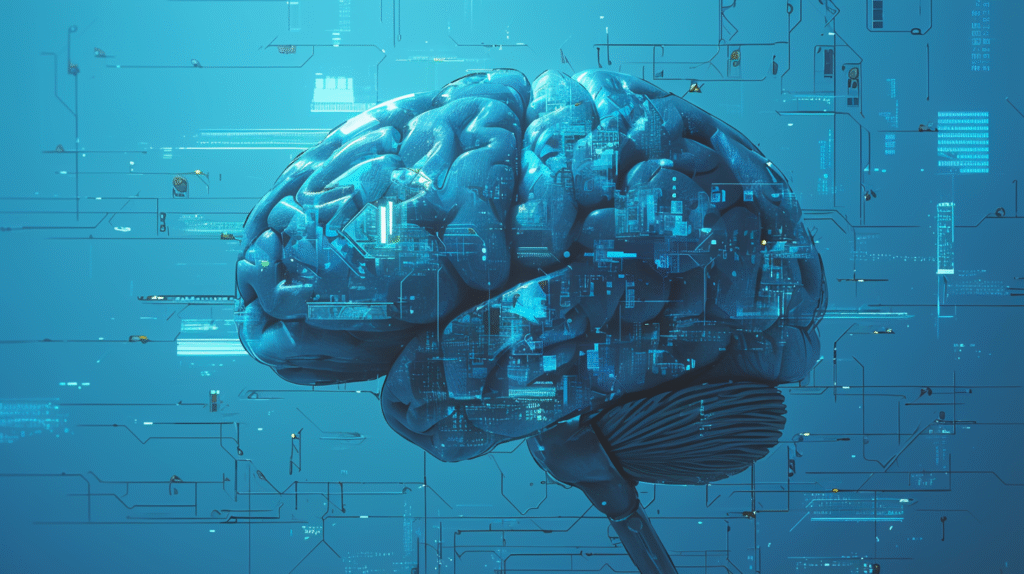

ディープラーニング(深層学習)を知っていますか?

現代のAI革命の中核技術として、画像認識から自然言語処理まで幅広い分野で革新的な成果を生み出しています。

本記事では、ディープラーニングの基本概念から最新トレンドまで、技術的詳細と実用的な応用を含めて網羅的に解説していきます。

ディープラーニングの基本的な定義と概念

機械学習との本質的な違い

ディープラーニングは機械学習の一分野です。 でも、従来の機械学習手法とは根本的に異なるアプローチを採用しているんです。

従来の機械学習では何が必要だったでしょうか? 人間が手動で特徴量を設計する必要がありました。

しかし、ディープラーニングは違います。 生データから自動的に有用な特徴表現を学習します。

この能力により:

- 画像のピクセル値

- 音声の波形データ

- その他の高次元で複雑なデータ

これらを直接処理することが可能になりました。

階層的学習の威力

階層的学習がディープラーニングの核心です。

どのように動作するのでしょうか?

初期層では:

- エッジ

- 角

- 基本的なパターン

これらを検出します。

深い層になるほど:

- 顔

- 物体全体

- 複雑な概念

これらを認識できるようになります。

この階層構造により、段階的に抽象度の高い表現を獲得し、複雑な非線形関係をモデル化できるんです。

ニューラルネットワークとの関係性

ディープラーニングは人工ニューラルネットワークの深層版と理解できます。

生物学的なニューロンの動作に着想を得た人工ニューロンを多層に接続します。 各ニューロンは:

- 入力に重みとバイアスを適用

- 活性化関数を通して出力を生成

数学的には、層lの変換は次のように表現されます: a^l = σ(W^l × a^(l-1) + b^l)

ここで:

- W^l:重み行列

- b^l:バイアスベクトル

- σ:活性化関数

なぜ「ディープ(深層)」と呼ばれるのか

「深層」という名称の由来を知っていますか?

ネットワークのCredit Assignment Path (CAP) の深さに由来します。

CAPとは何でしょうか? 入力から出力までのデータ変換の連鎖を指します。 この深さが2を超えるものを一般的に深層学習と呼びます。

なぜ深さが重要なのでしょうか?

理論的には、CAP深度2のネットワークでも万能近似器として機能します。 でも、より深いネットワークの方が効率的に複雑な特徴を抽出できることが実証されています。

深さにより:

- 指数関数的に表現力が向上

- 少ないパラメータでより複雑な関数を表現可能

ディープラーニングの仕組みと技術的詳細

ニューラルネットワークの層構造

ニューラルネットワークは3種類の層から構成されます。

入力層 生データを受け取る

隠れ層 段階的な変換を行う

出力層 最終的な予測を生成

各層のニューロン数と接続パターンが、ネットワークの容量と表現力を決定します。

深さと幅のバランス

隠れ層の深さと幅のバランスが重要です。

深いネットワークの特徴:

- 階層的な特徴を学習できる

- 勾配消失問題が発生しやすい

幅の広いネットワークの特徴:

- 並列処理能力が高い

- パラメータ数が増大

- 過学習のリスクが高まる

順伝播と逆伝播の仕組み

順伝播(フォワードプロパゲーション)

データが入力層から出力層へと流れます。

各層での処理:

- 線形変換を適用:z^l = W^l × a^(l-1) + b^l

- 活性化関数を通す:a^l = σ(z^l)

- この過程を繰り返し、最終層で予測値を得る

逆伝播(バックプロパゲーション)

予測誤差を基に各パラメータの勾配を効率的に計算するアルゴリズムです。

連鎖律を用いて、出力層から入力層へ向かって誤差を伝播させます。

出力層の誤差: δ^L = ∇_a C ⊙ σ'(z^L)

各層の誤差: δ^l = ((W^(l+1))^T δ^(l+1)) ⊙ σ'(z^l)

このように逆方向に伝播していきます。

活性化関数の役割と種類

活性化関数は非線形性を導入し、ネットワークに表現力を与える重要な要素です。

ReLU(Rectified Linear Unit)

最も広く使用されている活性化関数です。

式:f(x) = max(0, x)

利点:

- 単純な関数

- 勾配消失問題を緩和

- 計算効率が高い

注意点: 負の入力に対して勾配がゼロになる「dying ReLU」問題

Sigmoid関数

式:σ(x) = 1/(1 + e^(-x))

特徴:

- 出力を0から1の範囲に正規化

- 確率的解釈が可能

欠点: 大きな入力値で勾配が消失しやすい

Tanh関数

特徴:

- -1から1の範囲で出力

- ゼロ中心化されている

- 学習が安定しやすい

欠点: やはり勾配消失の問題を抱えている

Softmax関数

多クラス分類の出力層で使用され、確率分布を生成します。

損失関数と最適化アルゴリズム

損失関数

損失関数はモデルの予測誤差を定量化します。

回帰タスク 平均二乗誤差(MSE)を使用

分類タスク クロスエントロピー損失を使用

クロスエントロピーの利点:

- 確率分布間の差異を測定

- 誤った予測に対して強い勾配を生成

- 分類問題での学習が効率的

最適化アルゴリズム

損失関数を最小化するためにパラメータを更新します。

確率的勾配降下法(SGD) 基本的な手法

Adam(Adaptive Moment Estimation) 適応的学習率と運動量を組み合わせた手法

Adamの動作:

- 第一次モーメント(m_t)を追跡

- 第二次モーメント(v_t)を追跡

- 更新式:θ = θ – η(m_t/√(v_t + ε))

多くの場合で優れた性能を示します。

過学習と正則化技術

過学習は訓練データに過度に適合し、汎化性能が低下する現象です。

ドロップアウト

訓練時にニューロンをランダムに無効化します。

効果:

- モデルの冗長性を高める

- 単一のニューロンに依存しない頑健な特徴学習

L1/L2正則化

重みの大きさにペナルティを課し、シンプルなモデルを促進します。

L1正則化 Loss + λΣ|w_i| スパースな重みを生成

L2正則化 Loss + λΣw_i² 重みを均等に小さくする

バッチ正規化

各層の入力を正規化し、内部共変量シフトを軽減します。

効果:

- より高い学習率での安定した訓練が可能

- 学習の高速化

主要なディープラーニングモデルの詳細

CNN(畳み込みニューラルネットワーク)

CNNは画像認識の革命をもたらしたアーキテクチャです。

構造:

- 畳み込み層:フィルタを画像全体にスライドさせて特徴マップを生成

- プーリング層:空間次元を縮小

この構造により:

- 位置不変性

- 階層的な特徴抽出

これらが実現されます。

歴史的な発展

2012年 AlexNet

- 8層のCNN

- ImageNetの誤差率を26%から15.3%に削減

- 深層学習ブームの火付け役

VGGNet 均一な3×3畳み込みを採用

ResNet 残差接続により152層以上の超深層ネットワークを可能に

EfficientNet 深さ・幅・解像度を複合的にスケーリング

RNNとその発展形

RNN(再帰型ニューラルネットワーク)

系列データを処理するために設計されました。

隠れ状態の更新: h_t = f(W_h × h_{t-1} + W_x × x_t + b)

これにより過去の情報を保持します。

欠点: 長期依存性の学習時に勾配消失問題が発生しやすい

LSTM(Long Short-Term Memory)

3つのゲート機構でRNNの問題を解決:

- 忘却ゲート

- 入力ゲート

- 出力ゲート

セル状態が情報のハイウェイとして機能し、長期記憶を保持します。

GRU(Gated Recurrent Unit)

LSTMを簡略化した構造:

- リセットゲート

- 更新ゲート

2つのゲートで同等の性能を実現しながら、パラメータ数を削減。

Transformerアーキテクチャ

2017年に発表されたTransformerは、系列処理に革命をもたらしました。

自己注意機構

計算式: Attention(Q,K,V) = softmax(QK^T/√d_k)V

この式により、系列内のすべての位置間の関係を直接モデル化します。

利点:

- 並列処理可能

- RNNの逐次処理の制約を克服

主要コンポーネント

マルチヘッドアテンション 複数の注意ヘッドで異なる関係性を捉える

位置エンコーディング 系列の順序情報を保持

代表的なモデル

BERT 双方向のエンコーダ構造で文脈理解を深化

GPTシリーズ デコーダ構造で優れた生成能力

Vision Transformer(ViT) 画像認識にも応用され、マルチモーダルAIの基盤に

GAN(敵対的生成ネットワーク)

2つのネットワークが競争的に学習する革新的なアーキテクチャです。

生成器(Generator) ノイズから現実的なデータを生成

識別器(Discriminator) 本物と偽物を見分ける

このミニマックスゲームにより、極めて高品質な生成が可能になりました。

代表的なGAN

StyleGAN

- 段階的な解像度向上

- スタイル制御

- 写実的な顔画像生成

CycleGAN

- ペアでないデータ間の変換

- 画風変換などに応用

課題:

- モード崩壊

- 訓練の不安定性

オートエンコーダーとその応用

入力を圧縮(エンコード)し、元の形に復元(デコード)するネットワークです。

ボトルネック層 次元削減を強制し、有用な特徴表現を学習

変分オートエンコーダー(VAE)

- 確率的フレームワークを導入

- 潜在空間の正則化

- 生成モデルとしても機能

ディープラーニングの歴史的発展

基礎期から冬の時代へ(1940s-1990s)

1957年:パーセプトロン

Frank Rosenblattが開発したパーセプトロン。 学習可能な最初の人工ニューラルネットワークでした。

しかし、1969年にMinskyとPapertにより、XOR問題を解けないという根本的な限界が数学的に証明されました。 これが最初のAI冬の時代を招いたんです。

1986年:誤差逆伝播法

Rumelhart、Hinton、Williamsによる誤差逆伝播法の発表は画期的でした。

成果:

- 多層ネットワークの訓練を可能に

- 1989年の万能近似定理により理論的基盤も確立

しかし、計算資源の不足と勾配消失問題により、実用化には至りませんでした。

復活と2012年のブレークスルー

2006年:深層信念ネットワーク

Geoffrey Hintonらの研究により:

- 層ごとの教師なし事前学習

- 深層ネットワークの訓練が可能に

- 「ディープラーニング」という用語が誕生

2012年:AlexNetの勝利

ImageNet競技会での成果:

- 誤差率を26.2%から15.3%に大幅削減

- 2つのGPUを使用した並列処理

- ReLU活性化関数

- ドロップアウト

現代の深層学習の基本技術を確立しました。

成功の3つの要因:

- GPU計算の普及

- ビッグデータの利用可能性

- アルゴリズムの改善

現代の発展(2013-2025)

重要なマイルストーン

2016年 AlphaGo 囲碁世界チャンピオン李世乭への勝利 AIが直感的なゲームでも人間を超えることを証明

2017年 Transformer 自然言語処理に革命をもたらす

2022年 ChatGPT

- 2か月で1億ユーザーを獲得

- 史上最速で成長したアプリケーション

現在

- GPT-4やGPT-5などのマルチモーダルモデル

- テキスト、画像、音声を統合的に処理

- 基盤モデル(Foundation Models)の概念が確立

実用的な応用分野の詳細

画像認識・コンピュータビジョン

医療画像診断

深層学習モデルの成果:

- 放射線科医レベルの精度で疾患を検出

- 肺がん、脳腫瘍、網膜疾患の診断

具体例:

- Google DeepMind:50以上の眼疾患を診断可能

- メラノーマ検出:専門医を10%以上上回る精度

自動運転

実現されている技術:

- リアルタイムでの物体検出

- 車線認識

- 3Dシーン理解

企業の取り組み:

- Tesla:視覚ベースのニューラルネットワーク

- Waymo、Cruise:自律走行タクシーサービス

製造業

顕微鏡レベルの欠陥検出により品質管理が革新されています。

自然言語処理の革新

機械翻訳

Google翻訳

- 100以上の言語でニューラル機械翻訳

- リアルタイム会話翻訳も可能

テキスト生成と支援

ChatGPT

- 文章生成

- コーディング支援

- 分析タスク

- 数百万人が利用

GitHub Copilot プログラマーの生産性を大幅に向上

企業での活用

- カスタマーサービスの自動化

- 法的文書の分析と要約

- マーケティングコンテンツの生成

MicrosoftはGPTモデルをOfficeスイートやBing検索に統合。

音声認識と音声合成

音声アシスタント

- Apple Siri

- Amazon Alexa

- Google Assistant

深層ニューラルネットワークにより自然な会話を実現。 音声認識精度は最適条件下で95%以上。

応用技術

- リアルタイムの言語翻訳

- 音声クローニング

- アクセシビリティ向上

- 音楽生成AI

その他の重要な応用分野

医療分野

- 創薬研究の加速

- 個別化医療の実現

- ロボット支援手術の精度向上

深層学習医療市場は2025年までに134億ドルに達すると予測。

金融分野

- リアルタイムの不正検出

- アルゴリズム取引

- 信用スコアリングの高度化

- 規制コンプライアンスの自動化

科学研究

- AlphaFold:タンパク質折りたたみ問題を解決

- 気候モデリング

- 新材料発見

主要なフレームワークとツール

TensorFlowとPyTorchの比較

TensorFlow(Google開発)

特徴:

- エンタープライズ向けの強力な機能

- TensorFlow 2.xで動的実行がデフォルト

- Kerasとの統合で使いやすさが向上

エコシステム:

- TensorFlow Lite:エッジデプロイメント

- TensorBoard:可視化ツール

PyTorch(Meta開発)

特徴:

- 研究コミュニティで70%以上のシェア

- 動的計算グラフ

- Pythonらしい開発体験

- 優れたデバッグ機能

コミュニティ:

- 2024年には133%の貢献増加

- 3,500人以上の個人貢献者

その他の重要なツール

JAX

- Googleの高性能計算フレームワーク

- NumPyライクなインターフェース

- XLAコンパイル

Hugging Face

- 75万以上の事前学習済みモデルのハブ

- AIの民主化に貢献

ONNX

- モデルの相互運用性

- 異なるフレームワーク間でのモデル移植

クラウドプラットフォーム

Google Colab 無料でGPU/TPUアクセスを提供

AWS SageMaker、Azure ML 包括的なMLOpsソリューション

現在の課題と限界

データとリソースの要求

深層学習モデルの問題点:

- 大量のラベル付きデータが必要

- 手動アノテーションのコストが障壁

環境への影響:

- GPT-4のような大規模モデルの訓練:約50GWhの電力を消費

- 高性能GPUの供給不足と高コスト

- 小規模組織の参入が困難

技術的課題

ブラックボックス問題

- モデルの意思決定プロセスが不透明

- 医療や金融などの重要な分野での採用を妨げる

その他の課題:

- 敵対的攻撃への脆弱性

- 破滅的忘却:新しいタスクを学習する際に以前の知識を忘れる

- 訓練分布外でのデータへの汎化の困難さ

倫理的・社会的課題

- アルゴリズムバイアス:社会的不公平を増幅する危険性

- ディープフェイクによる誤情報の拡散

- AIによる職業の自動化と雇用への影響

- AIシステムの目標と人間の価値観の整合性

これらの社会的な課題への対応が急務となっています。

今後の展望と最新トレンド

エッジAIと効率的なモデル

モデル圧縮技術:

- 剪定

- 量子化

- 知識蒸留

これらにより、リソース制約のあるデバイスでのAI実行が可能に。

TinyML マイクロコントローラー上でのAI処理が実現

ニューロモルフィックチップ市場は2030年までに78億ドルに成長すると予測。

説明可能AI(XAI)

EU AI法などの規制により、アルゴリズムの透明性が要求されています。

開発状況:

- LIMEやSHAPなどの解釈可能性ツール

- 医療、金融、自動運転での信頼性向上

説明可能性はもはやオプションではなく、法的要件となりつつあります。

新たなパラダイム

量子機械学習

量子コンピューティング市場の予測:

- 2024年:13億ドル

- 2030年:154億ドル

古典的計算の限界を超える可能性を秘めています。

マルチモーダルAI

先導するモデル:

- GPT-4o

- Gemini

- Claude 3.5 Sonnet

テキスト、画像、音声、動画を統合的に処理。

効率性の追求

- パラメータ数の増加に頼らない性能向上

- Mixture-of-Expertsアーキテクチャ

- 持続可能なAI開発への転換

結論:深層学習の現在と未来

深層学習は1940年代の理論的概念から始まりました。 幾度かのAI冬の時代を経て、現在では社会インフラの一部となるまでに発展しています。

重要な節目

- 2012年 AlexNet:画像認識のブレークスルー

- 2017年 Transformer:自然言語処理の革命

- 2022年 ChatGPT:一般社会への普及

AIは私たちの日常生活に深く浸透しています。

技術的な成果

以下の特性により、従来の機械学習では不可能だった複雑な問題を解決:

- 自動特徴学習

- 階層的表現

- エンドツーエンド最適化

- スケーラビリティ

克服すべき課題

- データ要求

- 計算コスト

- 解釈可能性

- 倫理的課題

これらも明確になっています。

今後の重要テーマ

- 効率性と持続可能性

- 説明可能性と信頼性

- マルチモーダル統合

- エッジコンピューティング

量子コンピューティングやニューロモルフィック・コンピューティングなどの新しいパラダイムも、深層学習の可能性をさらに拡大させる可能性を秘めています。

深層学習は単なる技術革新を超えて、人類の問題解決能力を根本的に変革する力を持っています。

責任ある開発と活用により、より良い未来の構築に貢献すること。 それが私たち全員の課題となっています。